L'infrastructure informatique comprend également les infrastructures connexes. Cela inclut les technologies des centres de données, des réseaux et de la sécurité. Les centres de données sont des installations importantes qui fournissent des ressources de calcul et de stockage centralisées pour les applications d'IA. Ils doivent disposer de capacités de gestion et de maintenance efficaces. La technologie réseau permet de transmettre des données d'un emplacement à un autre et doit garantir la stabilité et la sécurité du réseau. La technologie de sécurité protège les données et les systèmes et doit garantir que les données ne seront ni divulguées ni attaquées. L'infrastructure informatique est un domaine diversifié et multiforme, dont le développement et la construction nécessitent la coopération et le soutien de toutes les parties prenantes.

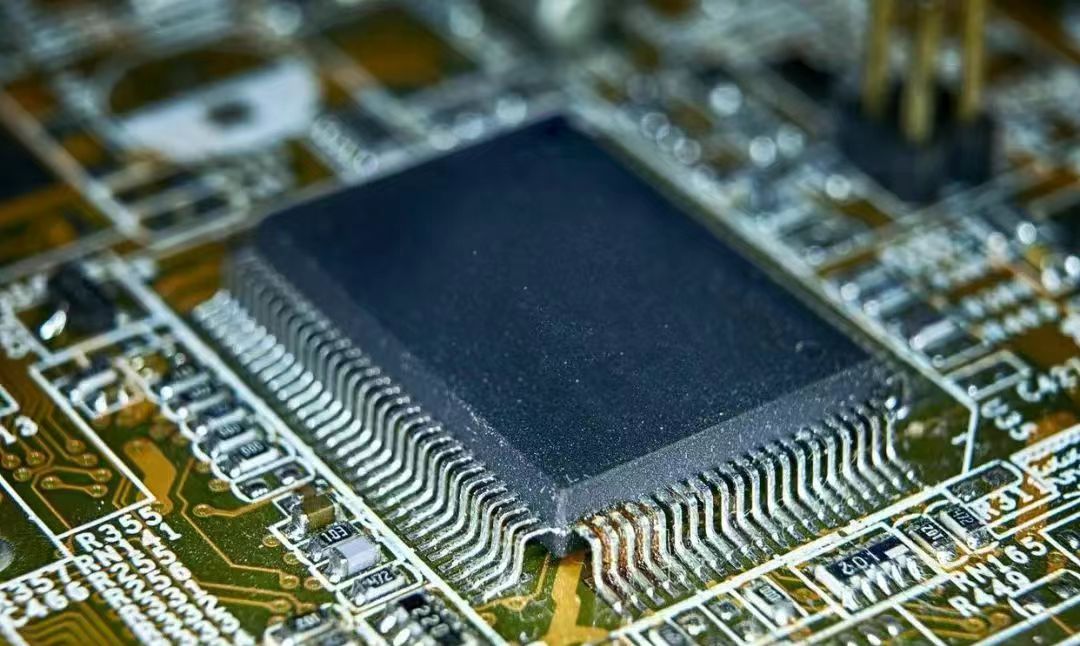

Le marché du calcul distribué par l'IA se compose principalement de trois segments : les puces informatiques (55-75 %), la mémoire (10-20 %) et les équipements réseau (10-20 %). Les puces informatiques, également appelées puces de calcul ou unités de traitement, sont des puces conçues spécifiquement pour effectuer des tâches informatiques. Comparées aux puces classiques à usage général, les puces informatiques sont optimisées pour des tâches spécifiques et offrent une efficacité de calcul supérieure pour une consommation énergétique réduite. Les puces informatiques ont un large éventail d'applications, notamment l'intelligence artificielle, le cloud computing, l'Internet des objets, le big data et d'autres domaines. Les puces d'IA, également appelées accélérateurs d'IA ou cartes de calcul, sont des modules dédiés à l'accélération d'un grand nombre de tâches informatiques dans les applications d'IA (les autres tâches non informatiques étant toujours gérées par le processeur). Du point de vue de l'architecture technique, les puces informatiques se divisent principalement en trois catégories : GPU, FPGA et ASIC. Ce sont les voies techniques permettant une commercialisation à grande échelle et le principal champ de bataille des puces d'IA. Le GPU est une puce d'intelligence artificielle polyvalente relativement mature, tandis que les FPGA et ASIC sont des puces semi-personnalisées ou entièrement personnalisées pour répondre aux besoins de l'intelligence artificielle. Le GPU est une puce optimisée pour des tâches de calcul telles que le rendu graphique et l'apprentissage profond, offrant les avantages d'un parallélisme élevé et d'une grande efficacité. Le GPU est un concept initialement proposé par NVIDIA lors du lancement de la puce de traitement graphique NVIDIA GeForce 256 en août 1999. Auparavant, la puce d'affichage qui traite les images de sortie de l'ordinateur était rarement considérée comme une unité de calcul indépendante.

Les fonctions des puces FPGA ne sont pas figées après leur fabrication. Les utilisateurs peuvent configurer les fonctions des puces FPGA selon leurs besoins réels grâce au logiciel EDA dédié fourni par le fabricant de puces FPGA, convertissant ainsi des puces FPGA vierges en circuits intégrés dotés de fonctions spécifiques.

Les puces mémoire sont largement utilisées. Serveurs, téléphones portables, PC et autres produits grand public ont tous besoin de puces mémoire, et le marché global est immense. La chaîne industrielle des puces mémoire comprend les fournisseurs de matières premières, les fabricants, les assembleurs et les testeurs, les fabricants de marques et les consommateurs finaux. Les fournisseurs de matières premières sont principalement responsables de la fourniture des matériaux de base tels que les plaquettes de silicium et les produits chimiques. Les fabricants de puces mémoire sont principalement responsables de la conception, de la fabrication, du conditionnement et des tests des puces mémoire. Les puces mémoire les plus courantes comprennent la DRAM, les mémoires flash NAND et les mémoires flash NOR.

Dans le domaine des serveurs, il peut être subdivisé en plusieurs types selon différents scénarios d'utilisation, tels que les serveurs de stockage, les serveurs cloud, les serveurs IA et les serveurs edge.

Parmi eux, les serveurs d'IA sont des serveurs conçus et optimisés spécifiquement pour les applications d'intelligence artificielle. Ils offrent une puissance de calcul, des capacités de stockage et de traitement de données puissantes pour le développement, l'entraînement et le déploiement d'applications d'IA. L'amont de la chaîne industrielle des serveurs d'IA est principalement constitué de matières premières telles que le processeur, le GPU, la mémoire, le disque dur, le contrôleur RAID et l'alimentation ; le milieu de la chaîne est l'industrie des serveurs elle-même ; les groupes de clients en aval comprennent les fournisseurs de services cloud Internet, les opérateurs de télécommunications, les fournisseurs de services IDC tiers, les administrations publiques et divers types d'entreprises. Les composants de base des serveurs d'IA comprennent le GPU (processeur graphique), la DRAM (mémoire vive dynamique), le SSD (disque SSD), la carte RAID, le processeur (unité centrale de traitement), la carte réseau, le circuit imprimé, la puce d'interconnexion haute vitesse (intégrée) et le module de dissipation thermique.