Datacenternas historia

Datacenter går tillbaka till 1940-talet. Den amerikanska militärens Electrical Numerical Integrator and Computer (ENIAC), färdigställd 1945 vid University of Pennsylvania, är ett tidigt exempel på ett datacenter som krävde dedikerat utrymme för att hysa sina massiva maskiner.

Med åren blev datorer mer storlekseffektiva och krävde mindre fysiskt utrymme. På 1990-talet kom mikrodatorer in på scenen, vilket drastiskt minskade mängden utrymme som behövdes för IT-verksamhet. Dessa mikrodatorer som började fylla gamla stordatorrum blev kända som "servrar", och rummen blev kända som "datacenter".

Tillkomsten av molntjänster i början av 2000-talet förändrade avsevärt det traditionella datacenterlandskapet. Molntjänster gör det möjligt för organisationer att få tillgång till datorresurser på begäran, via internet, med användningsbaserad prissättning – vilket möjliggör flexibilitet att skala upp eller ner efter behov.

År 2006 lanserade Google det första hyperskaliga datacentret i The Dalles, Oregon. Denna hyperskaliga anläggning upptar för närvarande 1,3 miljoner kvadratfot och sysselsätter cirka 200 datacenteroperatörer.1

En studie från McKinsey & Company förutspår att branschen kommer att växa med 10 % per år fram till 2030, med globala utgifter för byggande av nya anläggningar som når 49 miljarder USD.2

Typer av datacenter

Det finns olika typer av datacenteranläggningar, och ett enda företag kan använda mer än en typ, beroende på arbetsbelastning och affärsbehov.

Företagsdatacenter (lokala)

Denna datacentermodell hanterar all IT-infrastruktur och data lokalt. Många företag väljer lokala datacenter. De har mer kontroll över informationssäkerheten och kan lättare följa regler som Europeiska unionens allmänna dataskyddsförordning (GDPR) eller den amerikanska lagen om portabilitet och ansvarsskyldighet för sjukförsäkringar (HIPAA). Företaget ansvarar för alla driftsättnings-, övervaknings- och hanteringsuppgifter i ett företagsdatacenter.

Publika molndatacenter och hyperskaliga datacenter

Molndatacenter (även kallade molntjänstdatacenter) hyser IT-infrastrukturresurser för delad användning av flera kunder – från dussintals till miljontals – via en internetanslutning.

Många av de största molndatacentren – så kallade hyperskaliga datacenter – drivs av stora molntjänstleverantörer (CSP:er), såsom Amazon Web Services (AWS), Google Cloud Platform, IBM Cloud och Microsoft Azure. Dessa företag har stora datacenter i alla regioner i världen. Till exempel driver IBM över 60 IBM Cloud Data Centers på olika platser runt om i världen.

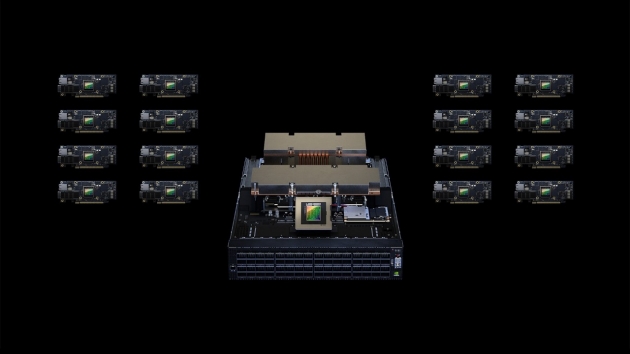

Hyperskaliga datacenter är större än traditionella datacenter och kan täcka miljontals kvadratmeter. De innehåller vanligtvis minst 4 000 servrar och kilometervis med anslutningsutrustning, och de kan ibland vara så stora som 6 000 kvadratmeter.

Molnleverantörer har vanligtvis mindre edge-datacenter (EDC) placerade närmare molnkunder (och molnkundernas kunder). Edge-datacenter utgör grunden för edge computing, ett distribuerat datasystem som för applikationer närmare slutanvändarna. Edge-datacenter är idealiska för realtidsdataintensiva arbetsbelastningar som stordataanalys, artificiell intelligens (AI), maskininlärning (ML) och innehållsleverans. De hjälper till att minimera latens, vilket förbättrar den övergripande applikationsprestanda och kundupplevelsen.

Hanterade datacenter och colocation-anläggningar

Hanterade datacenter och samlokaliseringsanläggningar är alternativ för organisationer som saknar utrymme, personal eller expertis för att hantera sin IT-infrastruktur lokalt. Dessa alternativ är idealiska för dem som föredrar att inte hosta sin infrastruktur genom att använda de delade resurserna i ett publikt molndatacenter.

I ett hanterat datacenter hyr kundföretaget dedikerade servrar, lagring och nätverkshårdvara från leverantören, och leverantören hanterar kundföretagets administration, övervakning och hantering.

I en colocation-anläggning äger kundföretaget all infrastruktur och hyr ett dedikerat utrymme för att vara värd för den inom anläggningen. I den traditionella colocation-modellen har kundföretaget ensam tillgång till hårdvaran och fullt ansvar för att hantera den. Denna modell är idealisk för integritet och säkerhet men ofta opraktisk, särskilt vid avbrott eller nödsituationer. Idag erbjuder de flesta colocation-leverantörer hanterings- och övervakningstjänster till kunder som vill ha dem.

Företag väljer ofta hanterade datacenter och samlokaliseringsanläggningar för att hysa fjärrsäkerhetskopiering och katastrofåterställningsteknik (DR) för små och medelstora företag (SMB).

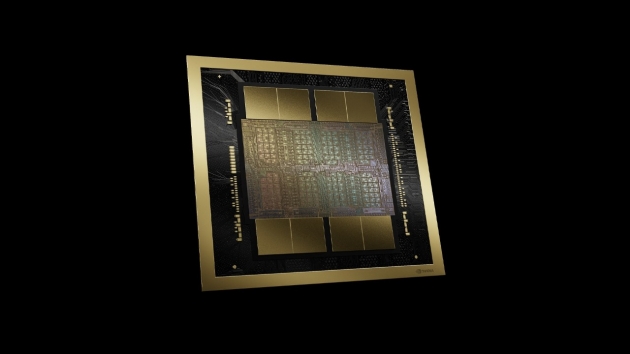

Modern datacenterarkitektur

De flesta moderna datacenter, inklusive interna och lokala, har utvecklats från den traditionella IT-arkitekturen. Istället för att köra varje applikation eller arbetsbelastning på dedikerad hårdvara använder de nu en molnarkitektur där fysiska resurser som processorer, lagring och nätverk virtualiseras. Virtualisering gör det möjligt att abstrahera dessa resurser från sina fysiska gränser och samla dem i kapacitet som kan allokeras över flera applikationer och arbetsbelastningar i de mängder de behöver.

Virtualisering möjliggör också programvarudefinierad infrastruktur (SDI) – infrastruktur som kan provisioneras, konfigureras, köras, underhållas och "spawnas" programmatiskt utan mänsklig inblandning.

Denna virtualisering har lett till nya datacenterarkitekturer som programvarudefinierade datacenter (SDDC), ett serverhanteringskoncept som virtualiserar infrastrukturelement som nätverk, lagring och beräkningskapacitet och levererar dem som en tjänst. Denna funktion gör det möjligt för organisationer att optimera infrastrukturen för varje applikation och arbetsbelastning utan att göra fysiska förändringar, vilket kan bidra till att förbättra prestanda och kontrollera kostnader. Datacentermodeller som en tjänst är redo att bli allt vanligare, och IDC förutspår att 65 % av teknikköparna kommer att prioritera dessa modeller år 2026.