Storia dei data center

I data center risalgono agli anni '40. L'ENIAC (Electrical Numerical Integrator and Computer) dell'esercito statunitense, completato nel 1945 presso l'Università della Pennsylvania, è uno dei primi esempi di data center che necessitava di uno spazio dedicato per ospitare le sue enormi macchine.

Nel corso degli anni, i computer sono diventati più efficienti in termini di dimensioni, richiedendo meno spazio fisico. Negli anni '90, sono entrati in scena i microcomputer, riducendo drasticamente lo spazio necessario per le operazioni IT. Questi microcomputer, che iniziarono a riempire le vecchie sale computer mainframe, divennero noti come "server", e le sale stesse come "data center".

L'avvento del cloud computing nei primi anni 2000 ha rivoluzionato radicalmente il panorama tradizionale dei data center. I servizi cloud consentono alle organizzazioni di accedere alle risorse di elaborazione on-demand, tramite Internet, con tariffe a consumo, garantendo la flessibilità di scalare verso l'alto o verso il basso in base alle esigenze.

Nel 2006, Google ha lanciato il primo data center hyperscale a The Dalles, in Oregon. Questa struttura hyperscale occupa attualmente 130.000 metri quadrati di spazio e impiega circa 200 operatori di data center.1

Uno studio di McKinsey & Company prevede che il settore crescerà del 10% all'anno fino al 2030, con una spesa globale per la costruzione di nuove strutture che raggiungerà i 49 miliardi di dollari.2

Tipi di data center

Esistono diversi tipi di data center e una singola azienda potrebbe utilizzarne più di uno, a seconda dei carichi di lavoro e delle esigenze aziendali.

Data center aziendali (on-premise)

Questo modello di data center ospita tutta l'infrastruttura IT e i dati on-premise. Molte aziende scelgono data center on-premise. Hanno un maggiore controllo sulla sicurezza delle informazioni e possono conformarsi più facilmente a normative come il Regolamento generale sulla protezione dei dati (GDPR) dell'Unione Europea o l'Health Insurance Portability and Accountability Act (HIPAA) degli Stati Uniti. L'azienda è responsabile di tutte le attività di implementazione, monitoraggio e gestione di un data center aziendale.

Data center cloud pubblici e data center iperscalabili

I data center cloud (chiamati anche data center di cloud computing) ospitano risorse infrastrutturali IT che possono essere condivise da più clienti, da decine a milioni, tramite una connessione Internet.

Molti dei più grandi data center cloud, chiamati data center iperscalabili, sono gestiti da importanti provider di servizi cloud (CSP), come Amazon Web Services (AWS), Google Cloud Platform, IBM Cloud e Microsoft Azure. Queste aziende dispongono di importanti data center in ogni regione del mondo. Ad esempio, IBM gestisce oltre 60 IBM Cloud Data Center in diverse località in tutto il mondo.

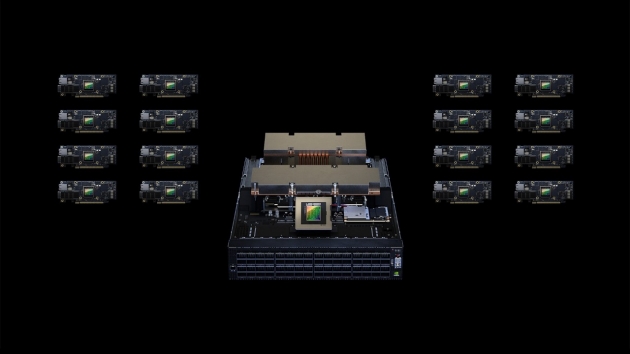

I data center hyperscale sono più grandi dei data center tradizionali e possono coprire milioni di metri quadrati. In genere contengono almeno 5.000 server e chilometri di apparecchiature di connessione, e a volte possono raggiungere i 60.000 metri quadrati.

I provider di servizi cloud in genere gestiscono data center edge (EDC) più piccoli, situati più vicini ai clienti cloud (e ai clienti dei clienti cloud). I data center edge costituiscono la base dell'edge computing, un framework di elaborazione distribuita che avvicina le applicazioni agli utenti finali. I data center edge sono ideali per carichi di lavoro in tempo reale ad alta intensità di dati, come l'analisi di big data, l'intelligenza artificiale (IA), il machine learning (ML) e la distribuzione di contenuti. Contribuiscono a ridurre al minimo la latenza, migliorando le prestazioni complessive delle applicazioni e l'esperienza del cliente.

Data center gestiti e strutture di colocation

I data center gestiti e le strutture di colocation sono opzioni per le organizzazioni che non dispongono di spazio, personale o competenze per gestire la propria infrastruttura IT in sede. Queste opzioni sono ideali per chi preferisce non ospitare la propria infrastruttura utilizzando le risorse condivise di un data center cloud pubblico.

In un data center gestito, l'azienda cliente prende in leasing server dedicati, storage e hardware di rete dal fornitore, il quale si occupa dell'amministrazione, del monitoraggio e della gestione dell'azienda cliente.

In una struttura di colocation, l'azienda cliente possiede tutta l'infrastruttura e affitta uno spazio dedicato per ospitarla all'interno della struttura. Nel modello di colocation tradizionale, l'azienda cliente ha accesso esclusivo all'hardware e la piena responsabilità della sua gestione. Questo modello è ideale per la privacy e la sicurezza, ma spesso risulta poco pratico, soprattutto durante interruzioni o emergenze. Oggi, la maggior parte dei fornitori di servizi di colocation offre servizi di gestione e monitoraggio ai clienti che li desiderano.

Le aziende spesso scelgono data center gestiti e strutture di colocation per ospitare tecnologie di backup remoto dei dati e di disaster recovery (DR) per le piccole e medie imprese (PMI).

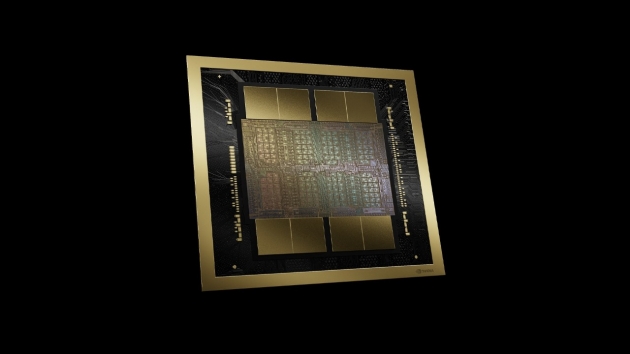

Architettura moderna del data center

La maggior parte dei data center moderni, compresi quelli on-premise, si è evoluta rispetto all'architettura IT tradizionale. Invece di eseguire ogni applicazione o carico di lavoro su hardware dedicato, ora utilizzano un'architettura cloud in cui le risorse fisiche come CPU, storage e networking sono virtualizzate. La virtualizzazione consente di astrarre queste risorse dai loro limiti fisici e di raggrupparle in capacità che può essere allocata a più applicazioni e carichi di lavoro nella quantità richiesta.

La virtualizzazione consente inoltre l'infrastruttura definita dal software (SDI), ovvero un'infrastruttura che può essere fornita, configurata, eseguita, gestita e "disattivata" a livello di programmazione, senza intervento umano.

Questa virtualizzazione ha portato a nuove architetture di data center come i data center software-defined (SDDC), un concetto di gestione server che virtualizza elementi infrastrutturali come networking, storage ed elaborazione, distribuendoli come servizio. Questa capacità consente alle organizzazioni di ottimizzare l'infrastruttura per ogni applicazione e carico di lavoro senza apportare modifiche fisiche, contribuendo a migliorare le prestazioni e a contenere i costi. I modelli di data center as-a-service sono destinati a diffondersi ulteriormente: IDC prevede che il 65% degli acquirenti di tecnologia darà priorità a questi modelli entro il 2026.