Datacentrenes historie

Datacentre stammer fra 1940'erne. Det amerikanske militærs Electrical Numerical Integrator and Computer (ENIAC), der blev færdiggjort i 1945 på University of Pennsylvania, er et tidligt eksempel på et datacenter, der krævede dedikeret plads til at huse sine massive maskiner.

Med årene blev computere mere størrelseseffektive og krævede mindre fysisk plads. I 1990'erne kom mikrocomputere på banen, hvilket drastisk reducerede den plads, der var nødvendig til IT-drift. Disse mikrocomputere, der begyndte at fylde gamle mainframe-computerrum, blev kendt som "servere", og rummene blev kendt som "datacentre".

Fremkomsten af cloud computing i starten af 2000'erne forstyrrede det traditionelle datacenterlandskab betydeligt. Cloudtjenester giver organisationer adgang til computerressourcer on-demand, via internettet, med pay-per-use-priser – hvilket giver fleksibilitet til at skalere op eller ned efter behov.

I 2006 lancerede Google det første hyperskala-datacenter i The Dalles, Oregon. Dette hyperskala-anlæg optager i øjeblikket 1,3 millioner kvadratfod og beskæftiger cirka 200 datacenteroperatører.1

En undersøgelse fra McKinsey & Company forudser, at branchen vil vokse med 10 % om året frem til 2030, med globale udgifter til opførelse af nye faciliteter, der når op på 49 milliarder USD.2

Typer af datacentre

Der findes forskellige typer datacenterfaciliteter, og en enkelt virksomhed kan bruge mere end én type, afhængigt af arbejdsbyrder og forretningsbehov.

Virksomhedsdatacentre (on-premise)

Denne datacentermodel hoster al IT-infrastruktur og data lokalt. Mange virksomheder vælger lokale datacentre. De har mere kontrol over informationssikkerhed og kan lettere overholde regler som f.eks. Den Europæiske Unions generelle forordning om databeskyttelse (GDPR) eller den amerikanske lov om portabilitet og ansvarlighed for sundhedsforsikring (HIPAA). Virksomheden er ansvarlig for alle implementerings-, overvågnings- og administrationsopgaver i et virksomhedsdatacenter.

Offentlige cloud-datacentre og hyperskala-datacentre

Cloud-datacentre (også kaldet cloud computing-datacentre) huser IT-infrastrukturressourcer til delt brug af flere kunder – fra snesevis af kunder til millioner – via en internetforbindelse.

Mange af de største cloud-datacentre – kaldet hyperscale-datacentre – drives af store cloud-udbydere (CSP'er), såsom Amazon Web Services (AWS), Google Cloud Platform, IBM Cloud og Microsoft Azure. Disse virksomheder har store datacentre i alle regioner i verden. For eksempel driver IBM over 60 IBM Cloud-datacentre forskellige steder rundt om i verden.

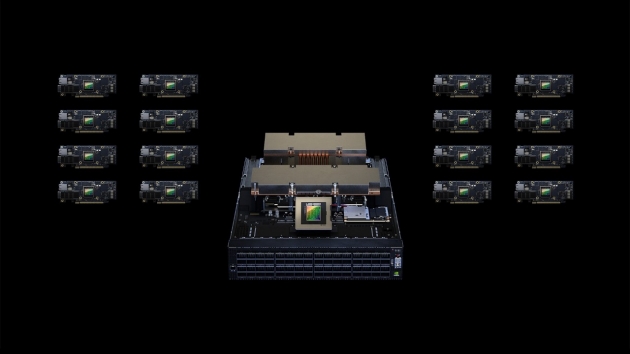

Hyperskala-datacentre er større end traditionelle datacentre og kan dække millioner af kvadratmeter. De indeholder typisk mindst 5.000 servere og kilometervis af forbindelsesudstyr, og de kan nogle gange være så store som 60.000 kvadratmeter.

Cloududbydere har typisk mindre edge-datacentre (EDC'er) placeret tættere på cloudkunder (og cloudkundernes kunder). Edge-datacentre danner fundamentet for edge computing, et distribueret databehandlingsframework, der bringer applikationer tættere på slutbrugerne. Edge-datacentre er ideelle til realtidsdataintensive arbejdsbelastninger som big data-analyse, kunstig intelligens (AI), maskinlæring (ML) og indholdslevering. De hjælper med at minimere latenstid, hvilket forbedrer den samlede applikationsydelse og kundeoplevelsen.

Administrerede datacentre og colocation-faciliteter

Administrerede datacentre og colocation-faciliteter er muligheder for organisationer, der mangler plads, personale eller ekspertise til at administrere deres IT-infrastruktur lokalt. Disse muligheder er ideelle for dem, der foretrækker ikke at hoste deres infrastruktur ved hjælp af de delte ressourcer i et offentligt cloud-datacenter.

I et administreret datacenter lejer klientvirksomheden dedikerede servere, lagerplads og netværkshardware fra udbyderen, og udbyderen håndterer klientvirksomhedens administration, overvågning og styring.

I en colocation-facilitet ejer klientvirksomheden al infrastrukturen og lejer et dedikeret område til at hoste den i faciliteten. I den traditionelle colocation-model har klientvirksomheden eneadgang til hardwaren og det fulde ansvar for at administrere den. Denne model er ideel for privatliv og sikkerhed, men ofte upraktisk, især under afbrydelser eller nødsituationer. I dag tilbyder de fleste colocation-udbydere administrations- og overvågningstjenester til kunder, der ønsker det.

Virksomheder vælger ofte administrerede datacentre og colocation-faciliteter til at huse fjernbaseret databackup og DR-teknologi (disaster recovery) til små og mellemstore virksomheder (SMV'er).

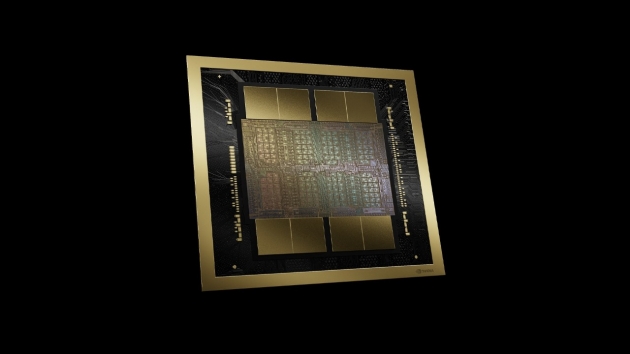

Moderne datacenterarkitektur

De fleste moderne datacentre, inklusive interne og lokale datacentre, har udviklet sig fra den traditionelle IT-arkitektur. I stedet for at køre hver applikation eller arbejdsbelastning på dedikeret hardware, bruger de nu en cloud-arkitektur, hvor fysiske ressourcer såsom CPU'er, lagerplads og netværk virtualiseres. Virtualisering gør det muligt at abstrahere disse ressourcer fra deres fysiske begrænsninger og samle dem i kapacitet, der kan allokeres på tværs af flere applikationer og arbejdsbelastninger i de mængder, de har brug for.

Virtualisering muliggør også softwaredefineret infrastruktur (SDI) – infrastruktur, der kan provisioneres, konfigureres, køres, vedligeholdes og "spun-down" programmatisk uden menneskelig indgriben.

Denne virtualisering har ført til nye datacenterarkitekturer såsom softwaredefinerede datacentre (SDDC), et serveradministrationskoncept, der virtualiserer infrastrukturelementer såsom netværk, lagring og beregning og leverer dem som en service. Denne funktion giver organisationer mulighed for at optimere infrastrukturen for hver applikation og arbejdsbyrde uden at foretage fysiske ændringer, hvilket kan bidrage til at forbedre ydeevnen og kontrollere omkostningerne. As-a-service datacentermodeller er klar til at blive mere udbredte, og IDC forudser, at 65 % af tech-købere vil prioritere disse modeller inden 2026.