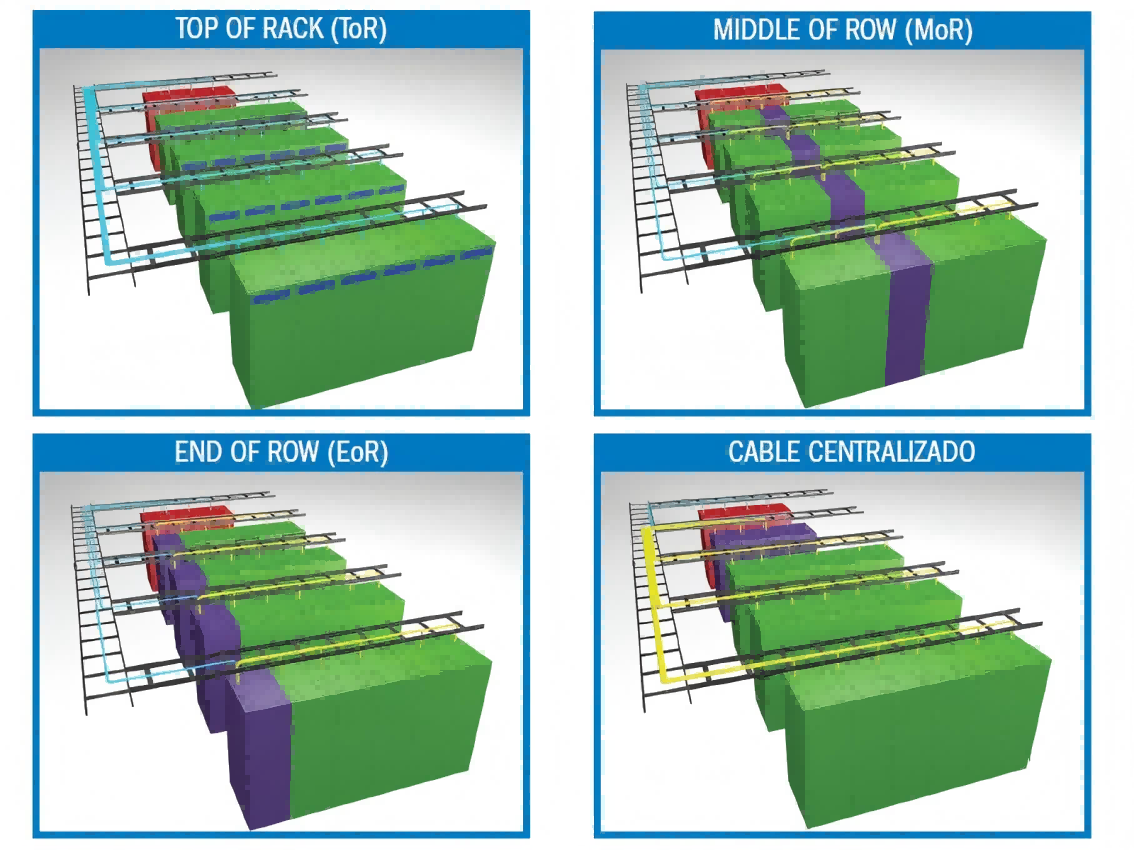

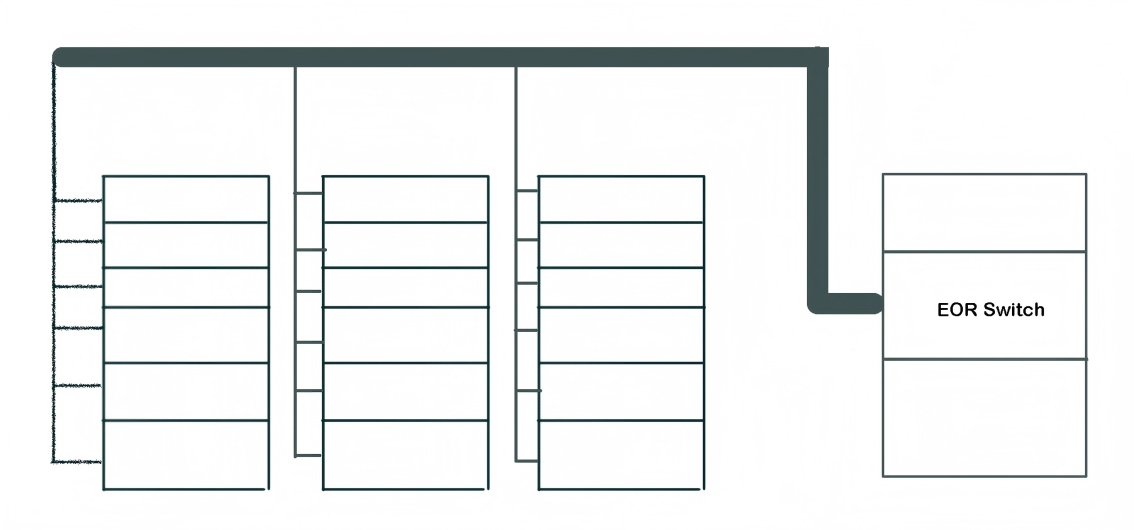

Ende der Reihe

Die End-of-Row-Architektur (EoR) platziert die Zugriffsswitches physisch am Ende jeder Serverreihe. Alle Server in dieser Reihe sind über Kabel mit dem jeweiligen Reihenend-Switch verbunden, der wiederum mit dem Core-Switch oder Router verknüpft ist, um einen umfassenderen Netzwerkzugriff zu ermöglichen.

Wichtigste Vorteile

Niedrigere Gesamtbetriebskosten: Die Konsolidierung der Switch-Hardware reduziert sowohl die anfänglichen Anschaffungskosten als auch die langfristigen Betriebskosten für Management und Wartung.

Effizienz der Aggregationsschicht: Benötigt im Vergleich zu verteilten Architekturen weniger Hochgeschwindigkeits-Uplink-Ports an Core- oder Aggregations-Switches.

Wirtschaftlicher Vorteil: Ist in der Regel kostengünstiger als der Einsatz von Switches im Top-of-Rack-Modell (ToR).

Wichtigste Einschränkungen

Distanzabhängige Leistungsbeschränkungen: Maximale Kabellängen vom Reihenend-Switch zu den Servern können die Signalintegrität einschränken und dadurch potenziell Latenz und maximalen Durchsatz beeinträchtigen.

Komplexität der Verkabelung: Erfordert umfangreiche horizontale Kabelverläufe, was zu dichten Kabeltrassen und einem anspruchsvolleren Patchpanel-Management führt.

Betriebliche Starrheit: Wartungsarbeiten und Hardware-Upgrades sind mit erheblichen Störungen verbunden, da sie einen Ausfall einer ganzen Serverreihe erfordern.

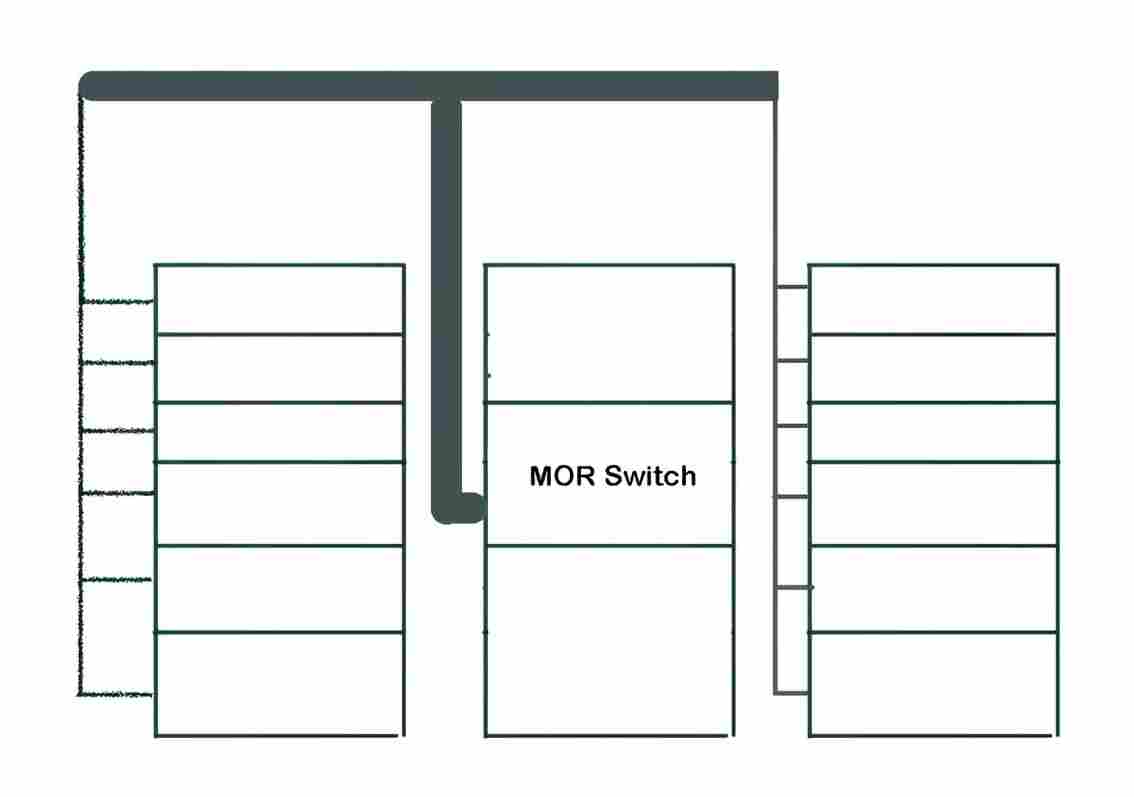

Mittlere Reihe

Die Middle-of-Row-Architektur (MoR) platziert einen Switch in der Mitte jeder Serverreihe. Die Server innerhalb der Reihe sind mit diesem zentralen Switch verbunden, der wiederum mit einem Core-Switch oder Router für die netzwerkweite Vernetzung verbunden ist. Der Hauptunterschied zur EoR-Architektur liegt in der reduzierten Kabellänge, da die Switch-Platzierung die Entfernung zu den am weitesten entfernten Servern minimiert. Andere Betriebskonzepte entsprechen weitgehend dem End-of-Row-Modell.

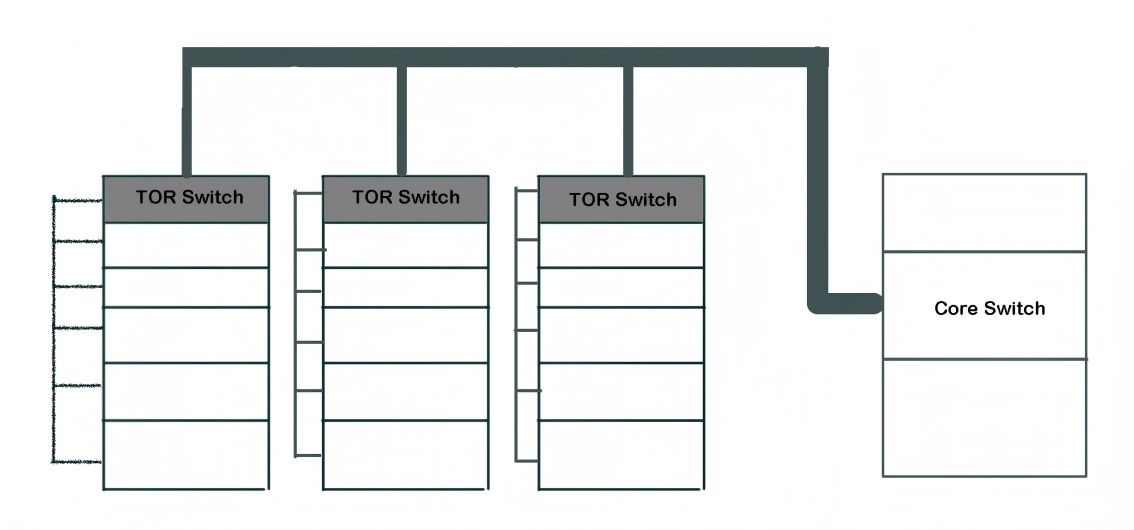

Top-of-Rack

Das Top-of-Rack-Design (ToR) platziert einen Hochleistungs-Switch oben auf jedem Serverrack. Durch die Verbindung der Server über den kürzestmöglichen Pfad ermöglicht dieser Switch latenzarmen Zugriff mit hoher Bandbreite und aggregiert den Rack-Datenverkehr effizient, bevor er ihn über Hochgeschwindigkeits-Uplinks an das Kernnetzwerk weiterleitet.

Wichtigste Vorteile

Einfache Bedienung: Die Kabelführung beschränkt sich auf das Innere des Racks, was die physische Infrastruktur und die tägliche Verwaltung erheblich vereinfacht.

Kosteneffiziente Implementierung: Nutzt kurze, preiswerte Kabel, wodurch die anfänglichen Material- und Installationskosten gesenkt werden.

Modulare Skalierbarkeit: Unterstützt eine granulare Erweiterung auf Rack-Ebene, ohne dass die gesamte Kabelinfrastruktur neu konzipiert werden muss.

Unabhängige Wartung: Ermöglicht Upgrades oder Fehlerbehebungen auf Rack-Ebene, ohne benachbarte Systeme zu beeinträchtigen.

Wichtigste Nachteile

Erhöhte Betriebskosten: Die zunehmende Verbreitung von Switches führt zu einem höheren Gesamtstromverbrauch und einem größeren Kühlbedarf, was die laufenden Kosten erhöht.

Managementkomplexität: Erfordert die Überwachung einer größeren Anzahl von Netzwerkgeräten, was den administrativen Aufwand erhöht.

Risiko der Ressourcenunterauslastung: Es kann zu ungenutzten oder verschwendeten Switch-Ports kommen, wenn nicht die gesamte Kapazität innerhalb eines Racks genutzt wird.