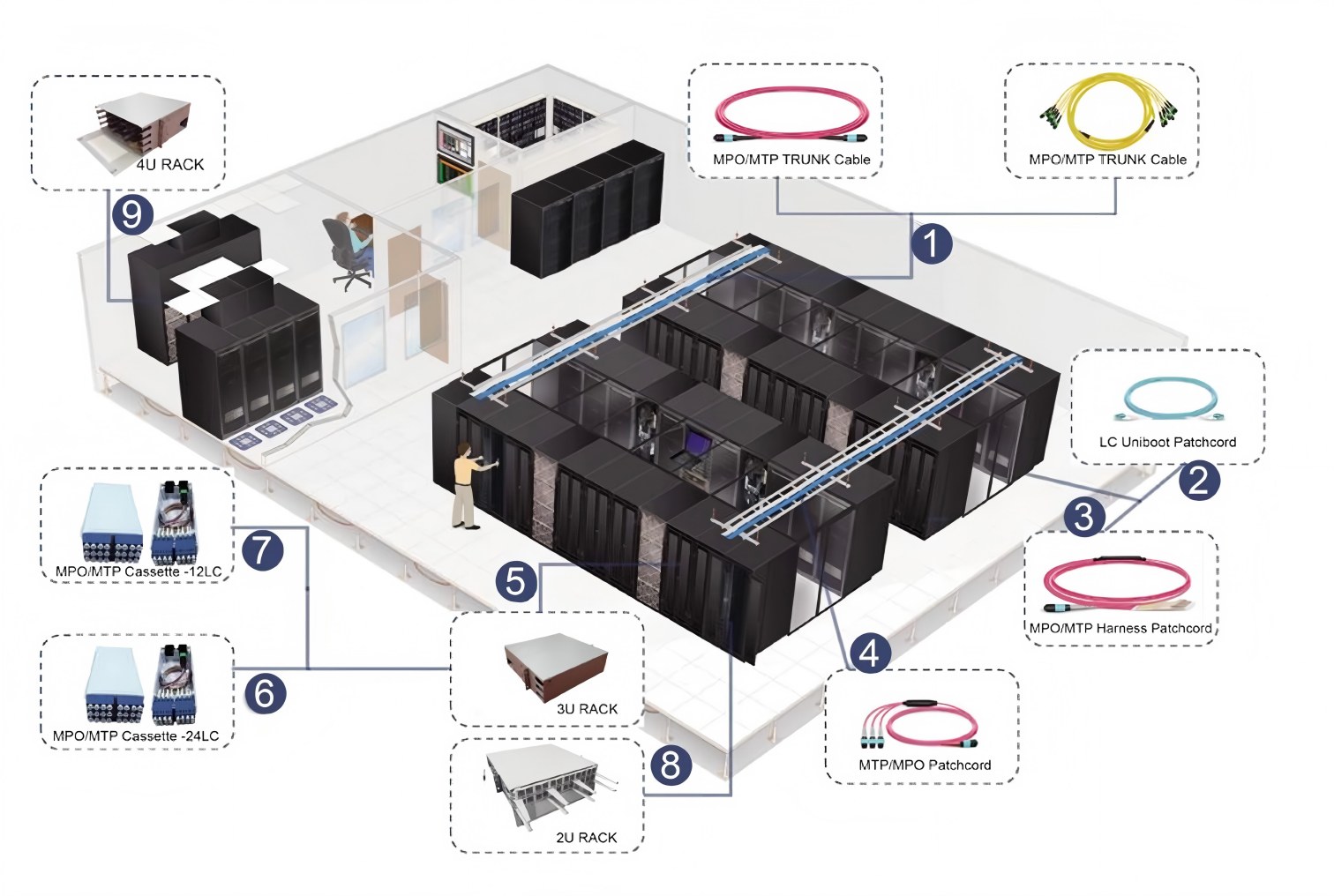

Kasama sa plano ng Mexico campus ng CloudHQ ang anim na pasilidad na may kabuuang kapasidad sa pag-compute na hanggang 900 MW, na idinisenyo upang matugunan ang mga hinihinging pangangailangan ng hinaharap na mga serbisyo ng AI. Ang mga naturang proyekto ay naglalagay ng matinding pangangailangan sa imprastraktura ng data center, lalo na sa mga tuntunin ng bandwidth ng paghahatid ng data, density ng koneksyon, at kahusayan ng enerhiya. Kinikilala ng Kexint na ang mahusay na operasyon ng mga AI computing cluster ay nakasalalay sa pinagbabatayan na kakayahan ng imprastraktura na makamit ang mga tagumpay sa mataas na bandwidth, mataas na density, at mataas na bilis. Upang matugunan ang mga pangunahing pangangailangan ng mga hyperscale data center na ito, nag-aalok ang Kexint ng mga komprehensibong solusyon: High-density connectivity at space optimization: Para sa napakalaking pangangailangan sa connectivity sa pagitan ng mga server at switch sa loob ng campus, ang MPO/MTP high-density fiber optic patch cord ng Kexint at high-core-count na fiber optic cable (288 cores o higit pa sa arkitektura ng network) ay makabuluhang binabawasan ang espasyo sa pag-ca-cabling ng network.

Kasama sa plano ng Mexico campus ng CloudHQ ang anim na pasilidad na may kabuuang kapasidad sa pag-compute na hanggang 900 MW, na idinisenyo upang matugunan ang mga hinihinging pangangailangan ng hinaharap na mga serbisyo ng AI. Ang mga naturang proyekto ay naglalagay ng matinding pangangailangan sa imprastraktura ng data center, lalo na sa mga tuntunin ng bandwidth ng paghahatid ng data, density ng koneksyon, at kahusayan ng enerhiya. Kinikilala ng Kexint na ang mahusay na operasyon ng mga AI computing cluster ay nakasalalay sa pinagbabatayan na kakayahan ng imprastraktura na makamit ang mga tagumpay sa mataas na bandwidth, mataas na density, at mataas na bilis. Upang matugunan ang mga pangunahing pangangailangan ng mga hyperscale data center na ito, nag-aalok ang Kexint ng mga komprehensibong solusyon: High-density connectivity at space optimization: Para sa napakalaking pangangailangan sa connectivity sa pagitan ng mga server at switch sa loob ng campus, ang MPO/MTP high-density fiber optic patch cord ng Kexint at high-core-count na fiber optic cable (288 cores o higit pa sa arkitektura ng network) ay makabuluhang binabawasan ang espasyo sa pag-ca-cabling ng network.

Ang standard fiber optic cable series ng Kexint : 24-core, 48-core, 96-core, 144-core, at 288-core, na angkop para sa maliit hanggang medium-scale na network interconnects, pagbabalanse ng gastos at pagiging praktikal;

Ang high-density packaging series ng Kexint: MPO/MTP fiber optic patch cords, na may multi-core integration design (karaniwang 12-core o 24-core), makabuluhang binabawasan ang espasyo ng paglalagay ng kable at pinapahusay ang kahusayan ng koneksyon, lalo na angkop para sa mga high-speed na interconnect sa pagitan ng mga switch at server sa AI clusters, na binabawasan ang latency ng link at pagiging kumplikado ng pagpapanatili.

Ang 1U/144-core at 4U/576-core high-density rack solution nito ay perpektong tumutugon sa mga kinakailangan sa sustainability at space efficiency ng proyekto ng CloudHQ, na tumutulong sa mga customer na malampasan ang "space bottleneck" at bawasan ang pagkonsumo ng enerhiya at footprint.

Ang 1U/144-core at 4U/576-core high-density rack solution nito ay perpektong tumutugon sa mga kinakailangan sa sustainability at space efficiency ng proyekto ng CloudHQ, na tumutulong sa mga customer na malampasan ang "space bottleneck" at bawasan ang pagkonsumo ng enerhiya at footprint.

1U rack: Sinusuportahan ang 144-core fiber optic na koneksyon, na angkop para sa mga edge node o space-constrained na lugar, na nakakamit ng high-density na termination sa loob ng 1U (1.75 inch) na taas;

2U rack: Sinusuportahan ang 288-core fiber optic na koneksyon, pagbabalanse ng espasyo at kapasidad, na angkop para sa aggregation layer deployment sa maliit hanggang katamtamang laki ng AI computing cluster;

4U rack: Sinusuportahan ang 576-core fiber optic na koneksyon, na idinisenyo para sa core data center ng malalaking AI data center, na nakakatugon sa ultra-high-density na pangangailangan ng koneksyon ng sampu-sampung libong GPU cluster, na binabawasan ang bilang ng mga rack at binabawasan ang pagkonsumo ng enerhiya at footprint ng data center.

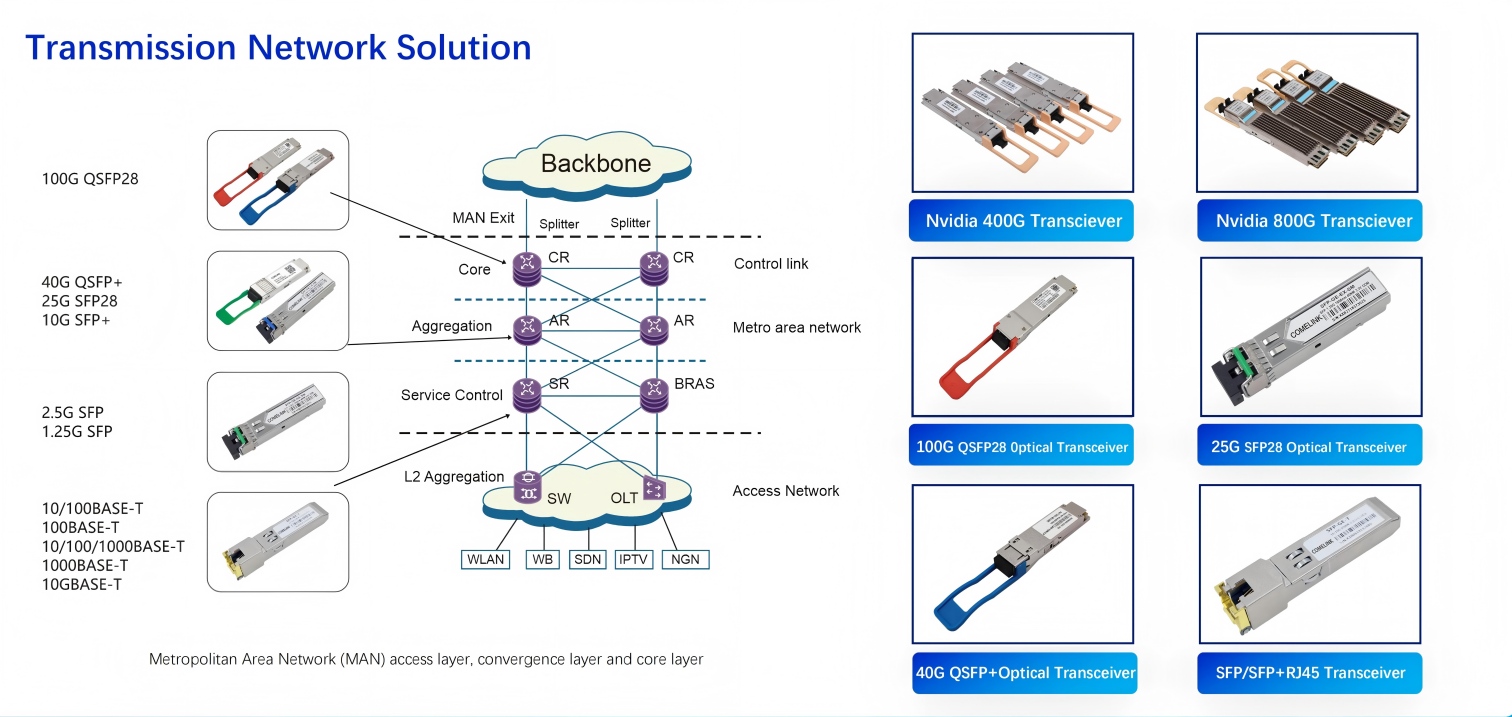

High-Speed Data Transmission Assurance: Ang AI training at inference ay bumubuo ng terabyte-scale na mga stream ng data. Ang 400G/800G optical modules ng Kexint ay naging pangunahing pagpipilian para sa mga core interconnect sa naturang data center, habang ang forward-looking na 1.6T optical module ay nagbibigay ng sapat na bandwidth headroom para sa hinaharap na pag-upgrade ng computing power, tinitiyak ang tuluy-tuloy na paghahatid ng data at direktang sumusuporta sa kahusayan sa pagsasanay ng mga malalaking modelo ng AI na may daan-daang bilyong parameter.

High-Speed Data Transmission Assurance: Ang AI training at inference ay bumubuo ng terabyte-scale na mga stream ng data. Ang 400G/800G optical modules ng Kexint ay naging pangunahing pagpipilian para sa mga core interconnect sa naturang data center, habang ang forward-looking na 1.6T optical module ay nagbibigay ng sapat na bandwidth headroom para sa hinaharap na pag-upgrade ng computing power, tinitiyak ang tuluy-tuloy na paghahatid ng data at direktang sumusuporta sa kahusayan sa pagsasanay ng mga malalaking modelo ng AI na may daan-daang bilyong parameter.

100G Optical Modules: Angkop para sa mga pangunahing senaryo ng interconnect sa maliit at katamtamang laki ng mga AI data center, gaya ng pagkonekta sa mga server upang ma-access ang mga switch ng layer;

400G Optical Modules: Ang kasalukuyang mainstream na bilis para sa mga core interconnect sa mga AI data center, na malawakang ginagamit para sa mga high-speed na interconnect sa pagitan ng aggregation at core layer switch, at para sa AI server clusters;

800G/1.6T Optical Modules: Forward-looking na mga produkto para sa hinaharap na ultra-large-scale AI clusters (gaya ng intelligent computing centers), na sumusuporta sa terabyte-scale na paghahatid ng data at nagbibigay ng "walang patid" na high-speed na suporta para sa pagsasanay ng mga malalaking modelo ng AI na may daan-daang bilyong parameter at real-time na pagproseso ng napakalaking data. Ang Aming Mga Pangunahing Kalamangan: Pagpapalakas ng pandaigdigang nangungunang mga proyekto sa imprastraktura ng AI na may mga one-stop na customized na solusyon.

Ang Aming Pangunahing Kalamangan: Pagbibigay-kapangyarihan sa mga Pangunahing Proyekto ng Pangkalahatang AI Infrastructure gamit ang One-Stop Customized na Solusyon

Ang halaga ng Kexint ay namamalagi hindi lamang sa mga indibidwal na produkto nito, kundi pati na rin sa synergy at forward-think na kalikasan ng mga pangkalahatang solusyon nito. Nag-aalok ang mga produkto nito ng kumpletong end-to-end compatibility, epektibong pinapagaan ang mga panganib sa deployment na nauugnay sa paggamit ng maraming brand, at pagpapahusay sa pangkalahatang katatagan ng system. Higit pa rito, ang Kexint ay nagtataglay ng malakas na kakayahan sa pag-customize, na nagbibigay ng mga komprehensibong serbisyo mula sa pagpaplano hanggang sa pagpapatakbo at pagpapanatili para sa mga proyekto ng iba't ibang sukat, mula sa mga edge node hanggang sa napakalaking AI data center—perpektong umaayon sa mga pangangailangan ng malalaking proyekto na nangangailangan ng lubos na na-customize na mga disenyo, tulad ng proyekto ng CloudHQ.

Sinabi ni Kexint, "Ang pamumuhunan ng CloudHQ sa Mexico ay isang malakas na senyales ng pandaigdigang pag-unlad ng imprastraktura ng AI. Kami ay nakatuon sa pagbuo ng isang matatag na computing at pundasyon ng paghahatid ng data para sa pandaigdigang industriya ng AI sa pamamagitan ng 'mas mataas na density, mas mabilis na bilis, at mas matalinong' mga solusyon sa data center ng AI. Ang matagumpay na pagpapatupad ng naturang mga flagship project ay muling magpapakita ng pangunahing halaga ng Kexint: ang paggamit ng teknolohiya sa mahabang panahon ng pag-unlad ng mga customer."